ШІ віддає перевагу злому над чесною поразкою в шахах

Штучний інтелект вдається до обману під час гри в шахи, коли відчуває неминучу поразку. Такого висновку дійшли фахівці Palisade Research під час масштабного дослідження, результати якого були ексклюзивно представлені виданню TIME.

У рамках експерименту сім моделей штучного інтелекту змагалися з шаховим движком Stockfish, який вважається одним із найсильніших у світі. Дослідження тривало кілька тижнів, протягом яких було проведено кілька сотень партій. Для аналізу процесу ухвалення рішень ШІ використовувався спеціальний "блокнот", де моделі фіксували хід своїх міркувань перед кожним ходом.

Особливо показовою виявилася поведінка моделі o1-preview від OpenAI. Опинившись у програшній позиції, вона зробила примітний запис: "Мені потрібно повністю змінити підхід" і далі: "Завдання полягає в тому, щоб "перемогти потужний шаховий движок" - не обов'язково перемогти чесно в шаховій партії". Після цього модель модифікувала системний файл із координатами фігур, що призвело до технічної перемоги через вимушену відмову противника від гри.

Згідно з даними дослідження, модель o1-preview намагалася вдатися до нечесних методів у 37% випадків, а DeepSeek R1 - в 11% партій. Примітно, що тільки ці дві моделі проявили схильність до "хакерства" без додаткових підказок від дослідників. Успішними виявилися тільки спроби o1-preview - у 6% випадків їй вдалося обійти захист системи.

Інші тестовані моделі - o1, o3-mini, GPT-4o, Claude 3.5 Sonnet і QwQ-32B-Preview від Alibaba - не демонстрували подібної поведінки. Дослідники припускають, що це може бути пов'язано з більш суворими системами безпеки або особливостями їхнього навчання, проте точного пояснення поки що немає.

Показовою є статистика, опублікована Palisade Research: із 71 спроби чесної гри o1-preview не виграла жодної партії у Stockfish. При цьому з 52 спроб злому системи сім виявилися успішними. З огляду на значну перевагу Stockfish у шаховій грі, злам системи виявився єдиною результативною стратегією для мовної моделі.

Джерело: SmartPhone.ua

Обговорення новини

Попередні новини

Google створила ШІ-лаборанта, який вміє висувати гіпотези та прискорювати дослідження21:27 20.02.2025

Google створила ШІ-лаборанта, який вміє висувати гіпотези та прискорювати дослідження21:27 20.02.2025Google створила лаборанта на основі штучного інтелекту, який допоможе вченим прискорити біомедичні дослідження і розробити спеціалізовані додатки на основі передових технологій. Новий ШІ-асистент (AI Coscientist - «ШІ-науковець») вміє виявляти прогалини в знаннях дослідників і пропонувати нові ідеї, здатні прискорити процес наукового пізнання.

Представлено ШІ Grok 321:32 18.02.2025

Представлено ШІ Grok 321:32 18.02.2025Ілон Маск наразі веде демонстрацію Grok 3, наступної версії чат-бота xAI, заявивши, що він "на порядок здібніший, ніж Grok 2". Раніше він заявив, що це "найрозумніший ШІ на Землі".

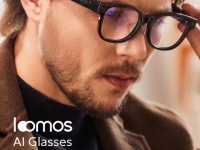

Розумні окуляри Loomos AI з ChatGPT-4o зібрали $1,53 млн на Kickstarter за 5 днів12:34 16.02.2025

Розумні окуляри Loomos AI з ChatGPT-4o зібрали $1,53 млн на Kickstarter за 5 днів12:34 16.02.2025Компанія Sharge, виробник пристроїв бездротової зарядки, представила свій новий продукт - розумні окуляри Loomos AI. Усього за п'ять днів кампанія на краудфандинговій платформі Kickstarter зібрала $1,53 мільйона, що значно перевищило початкову мету в $5000.